III-A-3

A - Usages et pratiques des patrimoines numérisés : une approche comparative[modifier | modifier le wikicode]

Documentarisation et redocumentarisation : du document d’archive à la collection patrimoniale documentarisée[modifier | modifier le wikicode]

Claire Scopsi / claire.scopsi(a)lecnam.net

Patrick Peccatte / peccatte(a)softexperience.com

Le concept de documentarisation, développé au début des années 2000, propose une posture d’analyse du document fondée sur son architecture interne et externe et l’articulation de ses composantes sémiotiques. Il permet de penser le document numérisé nativement numérique ou construit dynamiquement en continuité avec le livre, l’article ou le périodique traditionnels. À la fin des années 2010, les grands projets de numérisation de documents patrimoniaux et plus généralement la disponibilité sur le Web d’une masse croissante de documents et de données favorisent de nouvelles pratiques. Des narrations originales, construites par la sélection, l’assemblage et l’enrichissement de ces sources, voient le jour en ligne. Nous envisageons ici l’élargissement de la notion de documentarisation afin d’englober ces formes composites dans la notion de document. Après avoir rappelé les notions de documentarisation et de redocumentarisation, nous avançons que la documentarisation, dont l’approche traditionnelle considère les procédés donnant accès aux contenus, doit désormais prendre en compte et analyser les procédés d’enrichissement de ces contenus aboutissant à la production d’un supra-document composite. Puis nous montrons que cette nouvelle approche conduit à faire bouger les lignes méthodologiques et à reconsidérer, notamment, les notions d’originalité, d’intégrité et d’autorité.

Qu’est-ce que la documentarisation ?[modifier | modifier le wikicode]

Les concepts de documentarisation et redocumentarisation ont été initialement théorisés entre 2003 et 2006 par le groupe de recherches collectif Roger T. Pédauque, pseudonyme d’un réseau de scientifiques francophones travaillant dans divers domaines des sciences humaines et sociales ainsi que des sciences et techniques de l’information et de la communication[1]. L’objectif commun était de repenser le document dans la période de généralisation du Web et des techniques numériques.

Documentarisation[modifier | modifier le wikicode]

Le concept de documentarisation épouse l’évolution du document. À l’époque de Pédauque, Manuel Zacklad précise que, dans une logique collective, documentariser signifie doter un support d’attributs permettant de le gérer, de le manipuler, et de s’orienter à l’intérieur de son contenu sémiotique (Zacklad, 2004). Quels sont ces attributs ? Selon Jean-Michel Salaün, il s’agit de pratiques traditionnelles : cataloguer, indexer, découper, résumer, ‘renforcer’ (Salaün, 2007, p. 3). L’objectif annoncé s’applique à tous les types de support.

On peut distinguer deux types de procédés de documentarisation : interne ou externe. Les procédés de documentarisation internes (sommaire, pagination, ancre) visent à aider un lecteur à s’orienter à l’intérieur du document, à autoriser une lecture linéaire ou indexée des contenus, à en identifier les sous-éléments et la structure (chapitres, intertitres, etc.). Les procédés de documentarisation externes permettent, quant à eux, de relier les contenus à des éléments extérieurs (bibliographies, liens hypertextes), de les contextualiser, de donner des informations sur leur fiabilité ou leur provenance (notes), et enfin de rattacher le contenu et/ou le support à un ensemble (une série, une collection ou un assemblage sémantiquement pertinent).

Redocumentarisation – éditorialisation[modifier | modifier le wikicode]

L’année 2000 constitue un tournant avec l’accélération de la production de documents numériques, de la numérisation de documents préexistants, et de leur diffusion sur le Web. La gamme des attributs de la documentarisation s’enrichit d’attributs propres au numérique, et s’adapte aux nouvelles pratiques numériques : segmentation et identification de segments (URL, URI) en vue d’une recomposition sous forme de mash-up par exemple, mise en forme de données issues de bases de données et assemblées automatiquement pour composer un document doté de métadonnées de contexte (titre, date, auteurs, annotations, folksonomies, tags, notes, commentaires, etc.), enrichissements divers (réalité augmentée, liens hypertextes, géolocalisations, etc.). Manuel Zacklad parle alors d’éditorialisation, ce qui correspond à une documentarisation dans l’univers numérique.

On appelle parfois redocumentarisation, le traitement que l’on fait subir à un document déjà documentarisé sous sa forme analogique, lorsqu’il est numérisé et mis en ligne. S’il est “éclaté” pour être logé dans une base de données, la redocumentarisation vise à caractériser les différents éléments pour permettre la recomposition du document à la volée (Salaün, 2007).

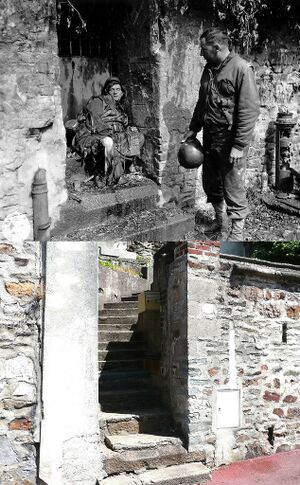

La redocumentarisation de fonds photographiques numérisés ouvre d’autres voies ; elle peut permettre d’identifier d’autres documents en ligne, en relation avec chaque cliché, par exemple d’autres photos appartenant à une même série, des séquences filmées en relation directe, des photos prises par d’autres photographes au même moment, des exemplaires de la photo transmis par radio (radiophoto ou bélino[2]), des annotations et légendes qui figurent sur le tirage d’origine, des versions recadrées ou colorisées utilisées sur différents supports, des versions censurées ou non censurées (selon le cas), des strates de légendes attribuées successivement au cliché, des utilisations de la photo à des fins publicitaires, sur des couvertures de livres, de disques, des affiches, sans oublier bien sûr les clichés récents réalisés au même endroit (pratique de la re-photographie – voir exemple ci-dessous). On peut ajouter à ces exemples, des documents textuels, articles, entretiens avec les photographes, ou notes personnelles qui apportent des informations sur les conditions dans lesquelles le cliché a été pris. Ce qui est notable dans ces procédés de redocumentarisation, c’est qu’ils ne visent pas uniquement à ménager l’accès au document, mais qu’ils l’enrichissent d’un sens nouveau en l’associant à d’autres documents.

Périmètre de la documentarisation/éditorialisation[modifier | modifier le wikicode]

Cet enrichissement d’un document par d’autres documents, s’apparente à ce que Gérard Genette (1987) nomme un épitexte[3] dans le contexte de l’édition de textes au 20e siècle. Ce qui change avec le numérique et le Web, ce sont les conditions dans lesquelles s’effectuent les opérations d’identification, de sélection et d’assemblage des éléments composant l’épitexte du texte (qu’il soit écriture, image ou son), et le choix des procédés d’enrichissements. Pour caractériser les formes de documentarisations numériques, il est nécessaire de prendre en compte les volumes traités, le type et le nombre d’acteurs impliqués, le degré d’automatisation du traitement, et enfin la finalité du traitement : produire des accès et/ou produire du sens. On distingue ainsi trois formes de documentarisation numérique :

- Les choix sont effectués, de façon raisonnée, par un auteur/éditeur qui crée du sens en contextualisant des documents, ou en mettant plusieurs documents en relation par des procédés éditoriaux. Cela procède d’une forme de curation, qui donne à voir un ensemble de documents peu nombreux et organisés manuellement. Cette forme d’éditorialisation, très orientée vers la production de sens, peut prendre la forme d’articles rédigés, d’expositions virtuelles ou de web-documentaire. Le site RetroNews[4], qui publie des articles thématiques fortement nourris et illustrés de documents issus de Gallica, en est un bon exemple. Nous y reviendrons dans la partie 2.

- Les enrichissements sont effectués collaborativement, par un groupe coordonné d’internautes, selon des règles partagées, et s’appliquent à des volumes importants de documents. La plateforme Testaments de poilus[5] qui organise la transcription collaborative, par des internautes, de lettres manuscrites de soldats, en est un exemple. PhotosNormandie[6], que nous détaillons plus loin, relève aussi de cette catégorie, qui parvient à produire du sens sur des volumes assez importants de documents, grâce au nombre des intervenants, à leur compétence, et à leur encadrement par des animateurs.

- Les enrichissements résultent de traitements algorithmiques et s’appliquent à de gros volumes de données contenus dans des bases de données, ou ‘crawlés’ par des moteurs d’indexation. Des tris, des regroupements, des affichages sont opérés automatiquement, sans qu’aucun être humain ne maîtrise l’ensemble des données, ni les résultats des traitements. Marcello Vitali-Rosetti (2016) considère que « l’éditorialisation est une instance de mise en forme et de structuration d’un contenu dans un environnement numérique ». C’est-à-dire que pour lui, les plateformes techniques (moteurs de recherche), les structures textuelles (hypertexte, métadonnées), et les pratiques humaines réparties (les commentaires, les annotations, les ‘like’) sont de l’éditorialisation.

On observe que le périmètre de définition du concept de documentarisation/éditorialisation évolue avec le contexte technologique et les usages émergents. Une gradation s’opère depuis le travail minutieux du passionné qui compose une anthologie en collectant et agençant sur le Web des documents d’archives, placés sur des pages et commentés pour construire une narration, jusqu’au moteur de recherche du Web qui sélectionne automatiquement et affiche côte à côte des documents issus du Web formant un lot pertinent pour l’algorithme de recherche.

De l’accès à l’enrichissement[modifier | modifier le wikicode]

Depuis l’époque du groupe Pédauque, le Web a beaucoup évolué et les pratiques des internautes ont considérablement changé. Désormais, l’objectif de la redocumentarisation n’est plus seulement l’optimisation de l’usage et l’amélioration de l’accès au document. Avec la multiplication des contenus produits ou publiés par les internautes, des archives ouvertes, des catalogues en ligne, etc. le travail de redocumentarisation produit de plus en plus de l’enrichissement, c’est-à-dire des informations et des liens entre documents qui produisent du sens. L’idée selon laquelle la redocumentarisation serait centrée sur les contenus des documents connus pour les gérer ou les contextualiser est donc très incomplète. Le passage des documents au numérique permet aussi de les réarranger, de les relier, et surtout de découvrir de nouveaux documents qui sont en relation. Les exemples du projet PhotosNormandie et de l’application RetroNews permettent d’illustrer ce point de vue.

Retrouver des séquences filmées en relation avec les photos [PhotosNormandie][modifier | modifier le wikicode]

Lancé fin janvier 2007 sur la plate-forme de partage d’images Flickr, PhotosNormandie est un projet collaboratif qui a pour but initial d’améliorer les légendes de plus de 5100 photos historiques de la bataille de Normandie. Les premiers résultats obtenus ont rapidement montré qu’il n’était pas possible de concevoir une photo du projet comme une entité autonome à renseigner individuellement. Chaque photo doit plutôt être considérée comme insérée dans un véritable réseau parfois complexe d’images et de pièces diverses. À partir d’une seule photo, de nombreux documents ou parties de documents doivent être recensés, décrits, analysés méticuleusement à l’aide de méthodes variées, et participer ainsi à la redocumentarisation (voir ci-dessus).

La recherche systématique de séquences filmées en relation avec les photos a progressivement pris une importante inattendue. Pour ce qui concerne l’armée américaine lors de la Seconde Guerre mondiale, les équipes chargées de “documenter la guerre en train de se faire” étaient formées d’un photographe et d’un cameraman qui opéraient presque toujours simultanément, filmant et photographiant ensemble les mêmes événements. Les images fixes et animées ainsi produites peuvent par conséquent être rapprochées et parfois s’éclairer mutuellement. Pourtant, ces relations sont demeurées longtemps négligées, probablement parce que les traitements d’archivage réalisés immédiatement après la guerre distinguaient radicalement deux médias largement tributaires de leurs propres méthodes de visualisation (papier et projection). La recherche systématique des liens entre images fixes et images animées n’avait jusqu’à présent jamais été entreprise avant l’initiative du projet PhotosNormandie. Elle a abouti en 2013 à l’ajout d’un corpus de 300 films historiques en libre accès sur YouTube, et tout travail documentaire sur une photo quelconque associe désormais une recherche (fructueuse ou non) dans la base des films. Environ une photo sur dix de la collection a ainsi pu être mise en correspondance avec une séquence filmée.

Identifier les premières publications des clichés dans la presse [PhotosNormandie][modifier | modifier le wikicode]

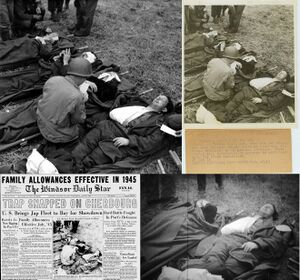

Un autre exemple est fourni par la recherche – systématique également – des premières publications des clichés dans la presse américaine et canadienne de l’époque. L’analyse est effectuée en priorité sur les sites (parfois payants) des journaux numérisés, mais aussi dans les magazines, les livres, les rapports. Les moteurs publics de recherche d’image par contenu sont inopérants puisqu’ils n’indexent pas les photos de ces collections numérisées. La seule méthode consiste à utiliser le travail d’observation réalisé par des humains (la « force brute ») en compulsant les collections numérisées page après page. En distribuant les titres à examiner entre les volontaires participants à la recherche, l’analyse a mis à jour des centaines d’articles de presse publiés peu après le Débarquement où figurent des photos de corpus initial. Une recherche similaire effectuée par le collectif PhotosNormandie sur les photos prises par Robert Capa à Omaha Beach le 6 juin 1944 a démontré aussi que ces clichés fameux sont parus dans de nombreux journaux nord-américains avant qu’ils soient publiés dans le magazine Life le 19 juin (date habituellement retenue par l’histoire du photojournalisme pour la publication de ces clichés). Cette dernière enquête est représentative de l’extension du champ de la redocumentarisation puisque les photos de Capa ne font pas partie du corpus initial.

Ces deux types d’investigations requièrent évidemment une très bonne mémoire visuelle des milliers de photos du corpus. Elles étendent le projet vers des objets qui ne figuraient pas initialement dans le corpus en question : des séquences filmées en relation avec les photos et des articles de presse où ces photos ont été publiées.

L’évolution des outils a bouleversé les approches documentaires en facilitant la découverte de documents nouveaux pertinents. Dans ce même domaine des images, il n’est plus guère possible de concevoir une recherche sans les outils publics de recherche d’image par contenu qui sont devenus banals (Tineye, Google Search by Images, Yandex, pour ne citer que les plus connus). Le passage au numérique incite à concevoir d’emblée une image analysée comme une occurrence particulière dans une classe d’images identiques potentiellement déjà publiées dont ces outils permettent d’appréhender parfois une partie. Plus généralement, un projet de redocumentarisation doit utiliser tous les outils disponibles du Web permettant la recherche et la mise en relation d’informations très diverses.

La redocumentarisation ne se limite donc pas à l’ajout de métadonnées nouvelles en vue de faciliter l’accès ou la recontextualisation des documents. C’est également un processus complexe qui permet de découvrir de nouveaux documents, d’insérer un document numérisé connu dans un réseau de documents qui ne sont pas toujours connus initialement. Autrement dit, il n’est pas possible de concevoir la redocumentarisation comme agissant sur une collection fermée. Le corpus de documents initial, n’est qu’un point de départ, il est foncièrement malléable et extensible, il peut s’étendre au fur et à mesure du progrès de la redocumentarisation et doit même pouvoir changer de nature. Le processus de redocumentarisation met à jour de nouvelles problématiques de recherche et produit une base de données évolutive qui doit pouvoir être continuellement augmentée de nouvelles informations et de nouveaux documents à analyser.

Produire des narrations anthologiques [RetroNews][modifier | modifier le wikicode]

Sur des corpus plus réduits, la redocumentarisation évolue vers des formes plus narratives, effectuées par un ou plusieurs individus, en groupe ou dispersés, qui transforment les éléments collectés en publications ouvertes et dynamiques, porteuses de savoirs nouveaux. Milad Doueihi perçoit dans ce « modèle d’assemblage de la fonction d’auteur » (2008, p. 70) une nouvelle forme de culture qu’il nomme anthologique[7] et qui procède à la fois de l’accès au savoir et de la production de savoirs. La pratique anthologique se déploie en raison de la numérisation croissante de fonds patrimoniaux, et parce que leur publication sur le Web rend accessible à tous un grand nombre de fac-similés numériques de documents issus de fonds patrimoniaux. Elle répond aussi à un besoin croissant d’organiser la masse d’information numérique, en sélectionnant quelques unités et en les assemblant pour produire une démonstration ou un récit. RetroNews, le site de presse de la Bibliothèque nationale de France (BnF), illustre cette tendance. Les sources proposées sont issues de Gallica, la bibliothèque numérique de la BnF, où chacun peut les consulter ; mais RetroNews propose des articles, illustrés et nourris de ces sources, rédigés par des chercheurs sur un mode volontairement vulgarisateur. On peut ainsi y consulter, à la façon de la presse quotidienne, une interview de Napoléon 1er depuis son exil de l’Île d’Elbe, un reportage sur l’assassinat de Raspoutine, ou un podcast de Louise Michel.

La valeur ajoutée de RetroNews réside dans cette éditorialisation thématisée, plaisante et pédagogique, de sources par ailleurs proposées beaucoup plus classiquement via la base de données de Gallica. L’anthologie participe donc à l’accès à la connaissance, mais sous une forme renouvelée. Il ne s’agit plus de ménager un accès technique au savoir, en produisant des catalogues ou des index, mais de créer une motivation intellectuelle, une raison pour le public de s’intéresser à ces documents-là. Ce procédé relève, dans la sphère culturelle, d’une économie de l’attention qui consiste à capter l’intérêt d’un public particulier pour l’orienter vers un produit culturel ou un savoir.

La publication croissante des documents d’archives numérisés sur le Web ne conduit pas seulement à de nouveaux usages publics. Elle nous oblige peu à peu à peu à reconsidérer la notion de document et son périmètre, et à nous questionner sur la pertinence des traitements documentaires traditionnels.

En quoi le document composite modifie-t-il notre perception des documents et leur documentarisation ?[modifier | modifier le wikicode]

Un document est caractérisé par une sémantique propre (son thème, son objectif, ce qu’il veut montrer, démontrer, etc.). On peut le concevoir métaphoriquement comme un “espace de pensée” apte à générer des informations ou d’autres documents. La redocumentarisation produit alors des documents nouveaux composés d’un assemblage de documents unitaires, de liens vers des documents unitaires déjà présents sur le Web, ou de documents originaux et reliés entre eux selon des logiques propres.

Nous proposons ici de considérer que l’essence de ces documents composites réside dans la logique d’assemblage qui préside à leur constitution, c’est-à-dire les procédés de sélection, d’ordonnancement et de mise à jour, définis par leurs auteurs. Dans une logique de traitement documentaire, cette nature composite pose quelques questions méthodologiques :

- Où réside l’originalité de ces documents composites, puisque leurs éléments unitaires sont eux-mêmes déjà identifiés, conservés, et publiés par ailleurs sur le Web ? Et par conséquent, sur quels éléments doivent porter les efforts de description et de conservation des ensembles redocumentarisés ?

- Comment l’intégrité des documents composites peut-elle être garantie ? Autrement dit, quelle est la version de référence de ces documents, alors que l’introduction de procédés d’intelligence artificielle pour agréger des documents unitaires en fonction de leur sens, ainsi que les enrichissements apportés par les internautes, modifient continuellement le périmètre des ensembles redocumentarisés ?

- À quel niveau se construit l’autorité de ces ensembles ? Les archives numérisées, circulent et s’intègrent au sein de plusieurs ensembles documentarisés. L’autorité du producteur initial de ces archives, suffit-elle pour construire la confiance dans les ensembles éditorialisés ?

Ces trois types d’évolution marquent clairement une rupture avec la conception de la redocumentarisation héritée du groupe Pédauque. L’accent presque exclusif porté sur l’optimisation de l’usage du document et l’amélioration de son accès à travers l’enrichissement de métadonnées n’est plus suffisant. Cette conception utilitaire de la redocumentarisation est désormais dépassée, elle doit faire place à une conception proprement heuristique au sens où les documents ne sont pas toujours donnés a priori mais doivent être découverts ou redécouverts selon de nouveaux points de vue, puis sélectionnés et organisés en fonction de perspectives émergentes.

Structurer l’espace numérisé est la valeur centrale des projets de redocumentarisation[modifier | modifier le wikicode]

En repensant le processus de redocumentarisation à partir du sens et du contenu des documents plutôt que de leur accessibilité, il peut être intéressant de concevoir la totalité des documents numérisés imaginables – qu’ils soient sur le Web ou ailleurs – comme un vaste ensemble flasque possédant des structures faibles, floues et peu apparentes. On peut le voir comme un espace numérisé sur lequel on cherche à découvrir de nouvelles informations, de nouveaux liens, de nouveaux documents, etc. à l’aide de méthodologies ad hoc, c’est-à-dire en utilisant des pratiques de recherche développées expressément à partir d’une catégorie précise de documents et pour répondre à des questions précises. L’objectif de la redocumentarisation est d’expliciter quelques-unes de ces structures faibles, de construire à partir de celles-ci de nouvelles micro-structures plus solides qui introduisent quelques îlots d’organisation dans cet espace largement désordonné. La redocumentarisation apparaît fondamentalement comme la création d’informations structurées sur un immense espace numérisé.

Mais où situer l’originalité de ces îlots de sens ? Les redocumentarisations de PhotosNormandie reposent sur des documents non originaux. D’une part parce qu’il s’agit des fac-similés numériques de clichés dont les exemplaires originaux (négatifs, tirages, pages de magazines…) sont conservés par ailleurs dans des collections physiques. Ces fac-similés sont déjà eux-mêmes publiés dans les bases de données ou les pages web des agences photos, des photothèques patrimoniales ou de collectionneurs qui en possèdent les droits de diffusion. Et pourtant, il est indéniable que les redocumentarisations de PhotosNormandie présentent un intérêt spécifique, original. Conserver les photographies de PhotosNormandie, n’a pas d’intérêt patrimonial. Ce sont les logiques d’assemblages, les commentaires, les liens entre les documents, qui constituent l’œuvre. Dans l’état actuel des pratiques professionnelles de conservation, les efforts portent presque toujours sur les documents unitaires, et très rarement sur les éléments d’assemblage. Ceux-ci sont le plus souvent liés à la structure logicielle de la plateforme de diffusion et disparaissent avec elle.

Le projet PhotosNormandie accorde une attention particulière aux logiques d’assemblage, c’est-à-dire aux intentions du contributeur qui a associé plusieurs documents, et a développé une méthode originale pour qu’elles soient consignées par ce contributeur, selon des règles de travail propres au projet. Le projet utilise la technique d’encapsulation des métadonnées descriptives à l’intérieur des images numériques selon des standards reconnus (IPTC/IIM et XMP[8]). Chaque photo haute résolution contient ses métadonnées descriptives, la description textuelle de l’image est donc toujours disponible avec l’image et facilement réutilisable. Par ailleurs, le projet n’est pas lié à la plate-forme grand public sur laquelle il est hébergé (Flickr) ni à la technologie de base de données déployée sur ce site pour l’exploitation de la collection documentée.

Il subsiste toutefois le problème de la pérennité des liens vers les ressources externes qui, par définition, ne peuvent être contrôlées. La stabilité de l’identification des ressources sur le Web n’est en général pas assurée et les liens peuvent être précaires. Ce problème demeure certainement l’une des plus grandes faiblesses des projets de redocumentarisation installés sur le Web. La solution retenue dans le projet PhotosNormandie est artisanale : à chaque image du corpus est attaché un véritable agrégat numérique (au sens archivistique du terme[9]) comprenant des textes, des images et des liens externes. Dans ces agrégats, des copies d’écran sont effectuées pour pallier la possible disparition des ressources externes (par exemple les articles de presse où une photo a été publiée).

Les solutions adoptées par PhotosNormandie montrent que les concepteurs du projet ont pleinement conscience du problème posé par la conservation pérenne de la logique d’assemblage des contenus enrichis. Elle souligne aussi le vide méthodologique que les auteurs ont dû compenser en utilisant les propriétés de l’image, et en élaborant des agrégats. Il en résulte inévitablement des redondances : les images unitaires déjà conservées par ailleurs sont à nouveau conservées avec leur enrichissement. Enfin la méthode de constitution de ces agrégats exige de l’application et du savoir-faire. Elle pourrait ne pas être transposable dans d’autres contextes.

* (haut, gauche) Réf. p012708, CR de Basse-Normandie/National Archives USA. Juin 1944, les équipes médicales américaines prennent en charge de nombreux civils victimes des combats engagés depuis le Débarquement. Photo prise à l’hôpital installé le 6 juin près de la ferme de La Houssaye à Sainte-Marie-du-Mont (Manche).

* (haut, droite) Radiophoto (photo transmise par radio avec sa légende), The Allison Collection, réf. 77.09.1722

* (bas, gauche) Cliché publié en Une du quotidien ‘The Windsor Daily Star’, 21 juin 1944

* (bas, droite) Photogramme extrait du film NARA 111-ADC-1911 en 5:13

Des espaces de pensées en constante évolution[modifier | modifier le wikicode]

Qu’ils soient enrichis par les internautes ou automatiquement par des algorithmes et des paramètres de recherche, les ensembles redocumentarisés sont des univers en constante expansion. Le processus de publication étant continuel, il n’est pas possible, comme dans l’édition traditionnelle, d’identifier des versions bien arrêtées et déterminées par les producteurs. Les institutions en charge du dépôt légal du Web[10] sont déjà confrontées à cette particularité du numérique, et elles ont choisi de construire artificiellement ces versions en « aspirant » périodiquement les sites. Une version correspond alors à l’état du site à la date d’aspiration. Dans l’état actuel de la technique, nous ne pouvons identifier autrement les états de publication de ces sites.

Une autre approche est possible : définir un ensemble du Web non selon son contenu exact à un moment donné, mais selon ses règles d’évolutions. Un exemple fameux est fourni par l’encyclopédie collaborative Wikipédia. Nous ne disposons pas de toutes les versions d’un article de Wikipédia, mais nous connaissons les règles de mise à jour, les modifications apportées, et les discussions qu’elles occasionnent. Cela permet, sinon de reconstituer a posteriori un état spécifique de l’article, tout au moins, de cerner le contexte et les enjeux de ses états successifs.

L’autorité déléguée des archives numériques[modifier | modifier le wikicode]

L’autorité des ensembles redocumentarisés pose des questions spécifiques. Comme indiqué plus haut, ces ensembles forment des narrations originales, reposant sur des assemblages ordonnés et raisonnés de documents glanés dans les collections accessibles sur le Web. Sur quoi pouvons-nous fonder la confiance en ces récits et déterminer leur fiabilité ? Deux notions doivent ici être distinguées : l’authenticité des documents produits, et la véracité du discours construit.

L’authenticité des éléments unitaires est le plus souvent garantie par l’institution ou la personne qui en possède l’original, l’a numérisé et publié sur le Web. Or nous n’accédons pas à ces originaux, mais à des copies, dont nous supposons l’intégrité. Notre confiance dans l’intégrité des fac-similés numériques repose sur la réputation de l’organisme qui les a produits, il faut donc que cet organisme soit identifié et que l’on en connaisse les missions, les méthodes de travail, et les obligations de transparence.

Mais cela ne suffit pas, car le fac-similé circule et pendant sa circulation peut subir des altérations de forme. Une image par exemple est recadrée, colorisée, etc. Elle perd aussi ses métadonnées : son titre, sa date de création, son auteur, son contexte de production peuvent être omis. Parfois son thème n’est plus clairement identifié. D’archive, l’image devient illustration. C’est-à-dire qu’elle ne vaut plus que par sa forme et ce qu’elle suggère, mais n’est plus utilisée en tant que trace et preuve d’un fait passé. Ainsi, dans les anthologies, ce n’est plus l’analyse de la forme, ou des métadonnées qui détermine l’authenticité des fac-similés d’archives, mais une autorité déléguée à l’institution ou à l’individu qui les utilise. La confiance est alors accordée à des sites de redocumentarisation dont les auteurs affichent des règles strictes : nommer les sources des documents, produire leurs métadonnées de contexte, respecter l’intégrité formelle du document ou tout au moins tracer les modifications qu’il a subies.

Cela ne suffit toujours pas, car l’on peut à partir de documents authentiques et intègres, produire un discours mensonger. La véracité du discours ne relève plus des éléments unitaires, mais du niveau de l’ensemble redocumentarisé. La réputation de ses auteurs, les règles de travail qu’ils édictent, leurs convictions, les causes qu’ils défendent, sont des indices qui nous permettent d’ajuster notre confiance. Enfin le dissensus, c’est-à-dire l’exposition à la discussion, à la vérification et à la contradiction des internautes, est un procédé spécifique d’évaluation de la véracité des discours ; c’est par ce procédé d’ouverture générale et permanente à la discussion que le projet PhotosNormandie justifie en grande partie l’autorité de sa production documentaire, conçue comme publiquement révisable et toujours perfectible.

Ces préoccupations sur l’autorité rappellent les interrogations formulées par la diplomatique en tant que méthode d’analyse de l’authenticité, de la véracité, de la sincérité, de la fiabilité des documents d’archives. Dégagée de son sens habituel de « science auxiliaire de l’histoire », la critique diplomatique moderne largement renouvelée par les travaux de Luciana Duranti vise en effet à fournir une méthodologie permettant d’identifier « les documents probants parmi l’ensemble des objets numériques existants » (Marie-Anne Chabin, 2011). Elle ouvre le champ à une diplomatique numérique, ou, selon le terme de Bruno Bachimont, une « philologie numérique » (Bachimont, 2010, p. 308) qui emprunte à la diplomatique classique, fondée au 17e siècle, non pas des méthodes ou des techniques, mais une culture, un esprit d’analyse et de critique orienté vers un ensemble de finalités similaires : dégager l’authenticité et la valeur des documents, retracer leurs transformations, comprendre et connaître leur utilisation. C’est en ce sens que la redocumentarisation, conçue comme structuration d’un espace numérisé, n’a en réalité jamais perdu son ancrage archivistique et patrimonial.

Les questions que soulèvent les ensembles redocumentarisés montrent que les pratiques numériques n’ont pas fini de mobiliser les théoriciens du document. Les concepts identifiés par Pédauque s’adaptent aux évolutions du document et en acceptent des définitions de plus en plus larges, tout en maintenant une grille d’analyse autonome et stable reposant sur des fondamentaux immuables : la preuve, la transmission, l’accès à la connaissance. C’est dans le domaine des pratiques professionnelles des gestionnaires de l’information et du patrimoine que les plus grandes difficultés se présentent. Passer de la description d’un document unitaire à un ensemble constitué est déjà une étape importante, mais les modèles descriptifs de l’ISAD-G/EAD[11] ou de CIDOC-CRM[12] l’ont déjà franchie. Cependant ces deux modèles s’appliquent à des collections pré-constituées par les services producteurs ou les donateurs. S’attaquer à la description d’ensembles documentaires constitués par l’usager, dans une logique de valorisation des archives numérisées, est un changement majeur et des modèles appropriés devront être pensés, des règles communes d’identification éditées. Les techniques de bases de données devront aussi évoluer, probablement à partir de modèles NoSQL plus adaptés au stockage de grandes quantités de documents. Or l’élaboration et la propagation des standards documentaires est une opération très longue qui se compte en dizaines d’années. D’ici là, les sites anthologiques et les corpus redocumentarisés devront, comme PhotosNormandie, développer leurs propres règles descriptives de leurs logiques structurelles. Les autres disparaîtront avec leurs plateformes, sans avoir pu migrer.

Bibliographie[modifier | modifier le wikicode]

● Bachimont, Bruno, 2010, La présence de l’archive : Réinventer et justifier. Association pour la Recherche sur la Cognition, 53‑54, pp.281-309. https://doi.org/<hal-00769664>

● Chabin, Marie-Anne, 2011, Peut-on parler de diplomatique numérique ?, août 2011, publié dans l’ouvrage Vers un nouvel archiviste numérique, sous la direction de Valentine Frey et Matteo Treleani, Paris, Éditions L’Harmattan, 2013 http://www.marieannechabin.fr/diplomatique-numerique/

● Crozat, Stéphane, 2012, Chaînes éditoriales et rééditorialisation de contenus numériques. In Lisette Calderan, Pascale Laurent, Hélène Lowinger, Jacques Millet, Le document numérique à l’heure du web, ADBS, pp.179-220, 2012, Sciences et techniques de l’information, 978-2-84365-142-7. hal-00740268 https://hal.inria.fr/hal-00740268

● Doueihi, Milad, 2010, Vers une culture anthologique. Documentaliste-Sciences de l’Information, Volume 47 (n° 1,), pages 59-60.

● Doueihi, Milad, 2011, Pour un humanisme numérique, Paris, Le Seuil

● Genette, Gérard, 1987, Seuils, coll. « Poétique ». Paris, Le Seuil

● ICA-Req, 2008, Principles and functional requirements for records in electronic office environments, International Council on Archives / Conseil International des Archives, ISBN: 978-2-918004-00-4 http://www.sa-fvg.archivi.beniculturali.it/fileadmin/materiali/ICA__Principles_and_Functional_Requirements_for_Records_in_Electronic_Office_Environments.pdf

● Pédauque, Roger T., 2006, Le Document à la lumière du numérique, avec une introduction de Jean-Michel Salaün et une préface de Michel Melot, Caen, C & F Éditions

● Salaün, Jean-Michel, 2007, La redocumentarisation, un défi pour les sciences de l’information. Études de communication, 30, 13-23 https://doi.org/10.4000/edc.428

● Sultan, Frédéric et Salaün, Jean-Michel, Roger T. Pédauque, l’aventure d’une écriture collective, http://base.d-p-h.info/fr/fiches/dph/fiche-dph-8220.html (mars 2010 ; consulté le 28 juillet 2020)

● Treleani Matteo, 2014, Les dispositifs de recontextualisation, in Mémoires audiovisuelles, collection « Parcours Numériques », Les Presses de l’Université de Montréal, Montréal, p. 109-131, ISBN: 978-2-7606-3368-1 http://www.parcoursnumeriques-pum.ca/les-dispositifs-de-recontextualisation

● Vitali Rosati, Marcello, 2016, Qu’est-ce que l’éditorialisation ?, Sens Public http://sens-public.org/article1184.html

● Zacklad, Manuel, 2004 (octobre 13), Processus de documentarisation dans les Documents pour l’Action (DopA) : Statut des annotations et technologies de la coopération associées. Numérique : impact sur le cycle de vie du document (Le), Montréal http://www.enssib.fr/bibliotheque-numerique/notices/1223-le-numerique-impact-sur-le-cycle-de-vie-du-document

- ↑ Ce groupe de recherche a été réuni à partir de 2003 par Jean-Michel Salaün dans un réseau thématique pluridisciplinaire (RTP) « Documents et contenu : création, indexation, navigation » du CNRS ; c’est l’acronyme RTP-Doc qui lui a donné son nom. Voir notamment : Roger T. Pédauque, 2006, Le Document à la lumière du numérique, avec une introduction de Jean-Michel Salaün et une préface de Michel Melot, Caen, C & F Éditions. Voir aussi la présentation du projet par Frédéric Sultan et Jean-Michel Salaün, Roger T. Pédauque, l’aventure d’une écriture collective, http://base.d-p-h.info/fr/fiches/dph/fiche-dph-8220.html (mars 2010 ; consulté le 28 juillet 2020).

- ↑ La radiophoto ou téléphotographie est l’envoi d’images par télégraphe, téléphone ou radio. Le bélinographe mis au point par Édouard Belin au début du 20e siècle, est un exemple de ces systèmes

- ↑ Dans une forme éditée, le paratexte tel qu’il est défini par Genette est un « ensemble hétéroclite de pratiques et de discours » qui entourent un texte. On y distingue :

- le péritexte, qui est intégré à la forme éditée : titre, sous-titre, préface, postface, prière d’insérer, avertissement, épigraphe, dédicace, notes, quatrième de couverture.

- l’épitexte, qui tout en étant extérieur à la forme éditée, vient la compléter : critiques, entretiens avec l’auteur, correspondance, journaux intimes, etc.

- ↑ RetroNews : https://www.retronews.fr

- ↑ Testaments de poilus : https://testaments-de-poilus.huma-num.fr/#!/

- ↑ FAQ du projet PhotosNormandie : https://dejavu.hypotheses.org/2998

- ↑ Au sens étymologique l’anthologie est la cueillette et l’assemblage de fleurs pour former un bouquet. Milad Doueihi parle aussi de « collections choisies » (2011, p.105).

- ↑ L’Information Interchange Model (IIM), est un standard de métadonnées mis au point par le consortium International Press Telecommunications Council (IPTC) au début des années 1990. Ces métadonnées sont intégrées aux fichiers des images (formats tiff, jpeg, jpeg2000, etc.) et sont décodées par les logiciels de gestion d’images. XMP est un format de métadonnées basé sur XML, lancé par Adobe et devenu un standard ISO en 2012. Pour les images, il remplace désormais le standard IPTC/IIM considéré comme obsolète.

- ↑ « Les agrégats électroniques (ou numériques) [aggregations of electronic records] sont des regroupements logiques d’enregistrements électroniques dont la combinaison forme une entité à un niveau supérieur au simple document ou objet électronique, par exemple un fichier ou une série. Ces relations se reflètent dans les liens des métadonnées, dans les associations qui existent entre les documents électroniques, et entre les documents et le système. » (Conseil International des Archives, ICA-Req, 2008, p. 44).

- ↑ Pour mémoire : la Bibliothèque nationale de France (BnF) pour le web français, l’Institut national de l’audiovisuel (INA) pour les sites web en relation avec les acteurs de l’audiovisuel, et le Centre national du cinéma et de l’image animée (CNC) pour le web en relation avec le cinéma.

- ↑ International Standard Archival Description-General (ISAD-G : Norme générale et internationale de description archivistique, qui permet de décrire et de contextualiser des collections de documents hiérarchisés.

- ↑ Le Conceptual Reference Model (CRM) du Comité International pour la DOCumentation (CIDOC) est un modèle sémantique de l'information relative au patrimoine culturel. Il permet de décrire des collections culturelles de musées ou de centres d’archives à l’aide de terminologies adaptées.